AI无处不在,能给你实实在在的帮助,这是当下的一个现实。你打开百度搜索,回答问题的是百度AI+,短暂的问题分析之后,一长串的专业解答自动生成;你想给孩子润色下综合测评的典型事例,直接把内容输入给豆包,几秒钟内就给你搞定;你想画个合心意的技术路线图放在刚写好的论文里,找kimi准没错……但我奉劝你,不要问AI“老婆饼里为什么没有老婆”这种蠢问题,也不要对它说谢谢,因为你对AI说的每句话,都会被它视为一次新的指令,这需要调用计算资源消耗大量算力来生成响应。

紧跟时代的人大概都知道AI耗电大、用水多,但对具体能耗有多大其实并没有实感。今天,请随科Way一起来算一算AI能耗这笔账。

—— PART 01 ——

AI的“吃电真相”

长久以来,全球电力需求一直保持相对稳定。工业、商业和居民生活三驾马车拉动着我们的用电量。工厂机器转动,商场电灯亮着,家里的冰箱空调开着,用电量和国家的经济发展、人民的生活水平直接挂钩,用电量变化趋势被预测。

但AI出现后的这几年,电力需求量持续激增。因为AI不仅需要更多芯片和服务器,也需要更大规模的数据中心。这些服务中心直接推高了全球电力需求。国际能源署(IEA)今年接连发布了几个相关的分析报告,将全球用电量激增的矛头直指数据中心和AI。

比如,IEA今年3月24日发布的《2025年全球能源评论》显示,2024年全球电力消耗增长超1080太瓦时,同比增长4.3%,相当于过去10年平均年增长率的2倍。IEA表示,快速扩张的数据中心成为最主要的推手,推动了全球用电量的大幅跃升。

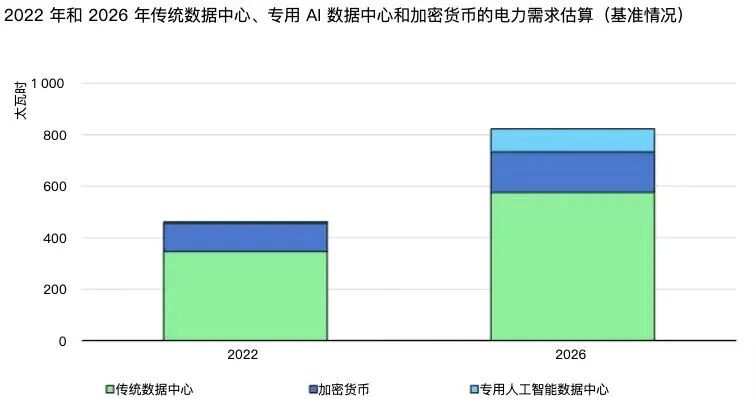

再如,在《电力2024》这份报告里,IEA用如下一张图,比较了2022年和2026年全球传统数据中心、AI专用数据中心和加密货币的电力需求估算。

从上图可见,2026年全球传统数据中心的用电量比2022年增长了近一倍,还新增了一个 AI专用数据中心。

AI的耗电主要集中在模型训练和模型推理两方面。在训练阶段,要向AI输入大量的数据,以此来构建并优化大语言模型。

一般来说,参数量越大,大模型的算力消耗就越大,其消耗的电能就越多。这就像给小孩子喂饭,喂得多吃得多,孩子才能长得又快又高又壮。以GPT-3大模型为例,其训练耗电总量大约为1280兆千瓦时,也就是128万度电,相当于6400个中国普通家庭一个月的用电量。

这里面还有一个重要的问题,训练模型需要的计算能力大概每3—4个月就会翻一倍。这就意味着,每一代新AI模型,会比前一代“更饿”,能源需求也会指数级增长。

模型推理阶段的耗电量则更超乎想象。虽然AI推理阶段单次能耗比训练阶段低,但由于推理阶段产生能耗的持续时间更长,加上高频调用,最终电力消耗的数字恐将是个天文数字。在全球已推出的数百个AI大模型中,仅ChatGPT每天就要消耗50万千瓦时电力来响应超过2亿条的用户请求。随着全球用户数量、使用频率的增加,耗电量也将不断累积。

业内人士估计,推理阶段的能耗,能占到AI生命周期总能耗的60%至90%。

需要强调的是,不论是模型训练还是模型推理,都需要数据中心的支持。这又是个特别能“吃电”的地方。一方面,数据中心的功率密度极高,一个大型数据中心的耗电量可相当于一个小城镇的工业总用电量;另一方面,数据中心通常全年无休,因为断电几秒就可能导致AI模型训练任务报废,造成数千万元甚至上亿元损失。

IEA今年4月发布的特别报告《能源与人工智能》预测,随着AI训练和推理任务的激增,到2030年,全球数据中心的电力需求预计将超过945太瓦时,较当前翻倍,略高于当前日本全年的总用电量。美国、中国和欧洲是主要增长区域。

—— PART 02 ——

AI还喜欢“喝水”

除了用电,AI运行也非常耗水。数据中心那些支撑AI运行的服务器,工作时会产生大量热量。我们每次向AI提问,对应的就是一次运算,服务器高速运转,机箱热得烫手。比如一个英伟达H100的GPU,功率是700—800W。一台服务器会有8到16个这样的GPU,再加上CPU、内存、存储,总功率超过10kW。运转一小时,产生的热量是36兆焦。

这样的一台服务器理论上能在几分钟内使一个50平方米的房间气温升高600摄氏度。当然,现实中因为空气是流动的,热量会散发,房间不可能达到这样的高温。但这足以说明,服务器产生的热量是巨大的。

降温的手段无非两种:风冷和水冷。随着AI部署的增加,机柜负载激增,风冷系统已无法有效处理这些高功率机柜负载所产生的热量。液冷技术就成为了数据中心散热的必然选择——使用液体作为冷却介质,相比空气,能更高效地带走热量。

像微软、谷歌这类大公司,全都用大量的水来散热。比如,谷歌的一个中型数据中心,一天的用水量,相当于1000个家庭的年用水量。你和ChatGPT聊上10到50个回合,可能就会用掉一瓶500毫升的矿泉水。

有机构预测,到2027年,全世界AI需求的用水量,可能达到每年42亿到66亿立方米。这是一个什么概念呢?这超过了英国年用水量的一半,是丹麦年用水量的4到6倍。

—— PART 03 ——

如何应对AI耗电问题?

前段时间,一则“人工智能已对全球电力系统造成严重破坏”的报道,引发公众对AI能耗的担忧,甚至出现了AI正在“吸干”全球电力的言论。

有人说,干脆不要用AI。这种做法是典型的因噎废食。毕竟,作为21世纪最具影响力的新兴技术之一,AI给人类生活带来了积极的影响——如今的AI不仅能生成文本、图片和音频,还能预测天气、使机器人更智能灵活、自动化工作流程以及感知解读物理世界。

那么,如何解决AI耗电问题?

有业内人士建议,从供应端入手,不断增加供电量,以解决AI耗电问题。

具体的做法是:以风电、光电及储能技术为重要突破口。

如下表所示,一些科技巨头选择签订PPA(电力购买协议),直接与可再生能源项目开发商签长期合同,确保未来10—20年的稳定绿电供应。

不过,PPA虽然可以锁定长期绿色电力供应,但无法解决风光电力间歇性的问题。对于需要24小时稳定运行的数据中心来说,储能系统是保证稳定供电的关键。

储能可以实现在电价较低时充电,电价较高时放电,直接降低用电成本;还能在电网掉电的关键时刻以毫秒级速度顶上,保障计算不中断;更能和光伏、风电配套,让数据中心园区实现局部“独立供能”。

各国相关案例显示,储能正在从“可选项”变成“标配”。比如,中国颁布的新规已将储能纳入绿色数据中心的核心推荐标准;印尼雅加达在建的数据中心将配套120MWh电池储能系统;美国Redwood的二次电池微电网为高耗能AI数据中心提供供电保障;澳大利亚Allegro Energy以液流电池长时储能技术支撑数据中心用能。

而在需求端,包括算法优化、硬件改进和能源管理等方面都有节能潜力可以挖掘。算法优化可以在不显著降低AI性能的情况下,减少计算量和能耗。有业内人士建议,包括芯片在内的硬件改进,是解决AI耗电问题的重要途径,未来量子计算、光子计算等新型计算技术也可大幅提升计算效率,减少能耗。

此外,在AI数据中心能源管理上,使用先进的冷却技术和智能电力管理系统,都能有效降低AI的能耗。